Rambus在8月25日宣布推出HBM3内存接口子系统

发布时间:2021-01-26 11:16:37编辑:xiaowu

Rambus在8月25日宣布推出HBM3内存接口子系统,昨天美国内存 IP 厂商Rambus将这个好消息进行了公布,这个内存系统拥有非常快速的传输速度,能够达到8.4Gbps。能够运用在各种的智能科技上,是人工智能等智能机械等都需要使用的一个系统。在接下来的时间里,它还会运用在各种的数据领域。

芯东西等媒体与 Rambus 大中华区总经理苏雷、Rambus IP 核产品营销高级总监 Frank Ferro 就 Rambus HBM3 的具体性能以及 Rambus 对客户的支持等进行了深入交流。

一、支持 8.4Gbps 数据传输速率,带宽超 TB

据 Frank 分享,随着越来越多的公司进入人工智能市场,这对内存带宽提出了很多要求,而神经网络和深度学习等 AI 应用也在不断推动内存带宽增长。

咨询公司 IDC 内存半导体副总裁 Soo Kyoum Kim 曾称:“AI/ML 训练对内存带宽的需求永无止境,一些前沿训练模型现已拥有数以十亿的参数。”

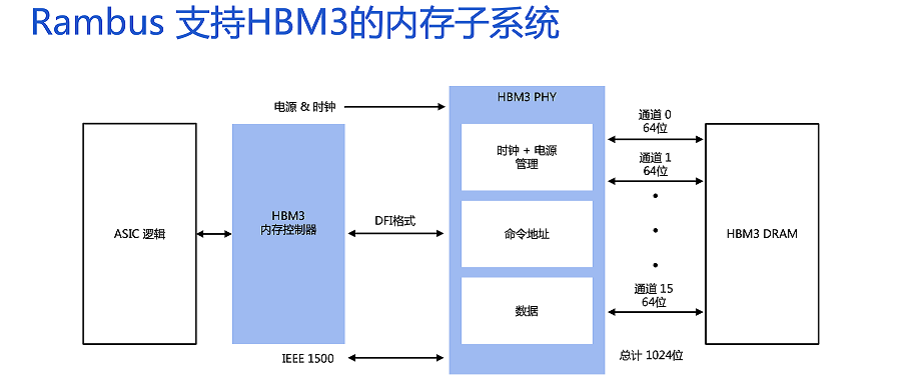

Rambus 的 HBM3 内存子系统提高了原有性能标准,包含完全集成的 PHY 和数字控制器,可以支持当下很多 AI 及 HPC 应用。

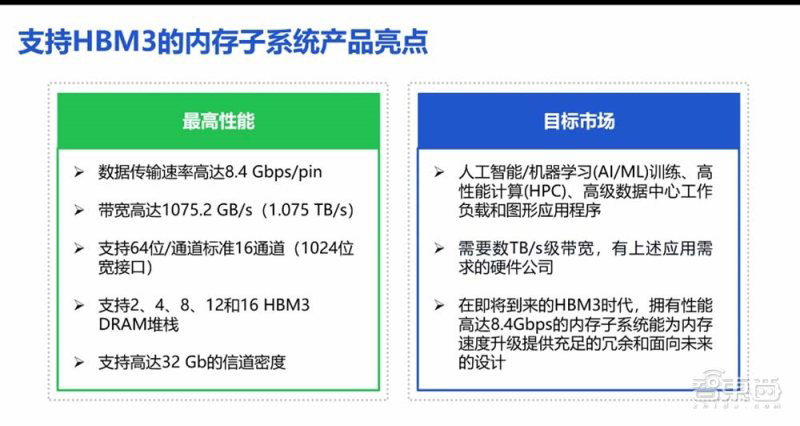

具体来说,HBM3 的数据传输速率高达 8.4Gbps/pin,带宽达 1075.2GB/s(1.075TB/s)。Rambus 的 HBM3 支持标准的 64 位 16 通道,支持 2、4、8、12 和 16 HBM3 DRAM 堆栈,信道密度达 32Gb。

Frank 回应芯东西记者问题时称,HBM3 的流片时间预计为 18 个月,因此可能会在 2022 年末或 2023 年初出片,并实际应用于部分客户。

Frank 称,由于其数据传输速率和带宽较高,HBM3 可以应用于 AI、机器学习、HPC 等多种应用。

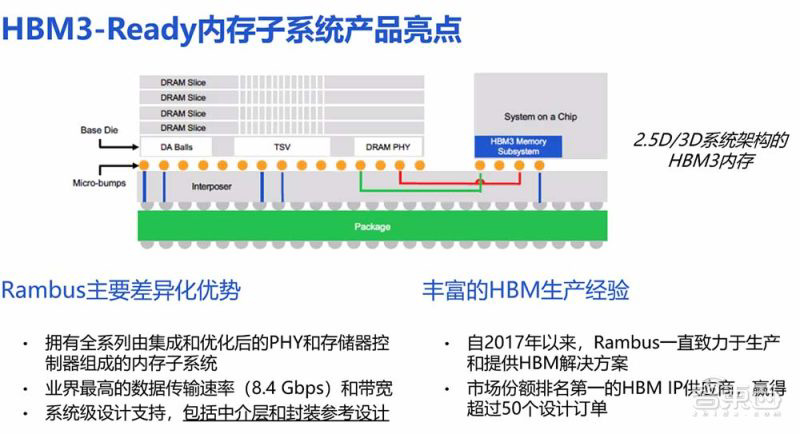

HBM3 采用了 2.5D 架构,最上面集成了 4 条 DRAM 内存条,通过堆叠的方式集成在了一起。内存条下方是 SoC 和中介层,最下面的绿色部分则是封装。

对客户来说,Rambus 会提供 SI/PI 专家技术支持,确保设备和系统具有最优的信号和电源完整性。作为 IP 授权的一部分,Rambus 也将提供 2.5D 封装和中介层参考设计。

2016 年 HBM2 的带宽为 256GB/s,I/O 数据速率为 2Gbps;HBM2E 的带宽则能达到 460GB/s,数据传输速率达 3.6Gbps;SK 海力士公布的 HBM3 带宽和传输速率分别为 665GB/s 和 5.2Gbps;Rambus 的 HBM3 性能又进一步提升,分别达 1075GB/s 和 8.4Gbps。

Frank 强调,虽然 Rambus 的 HBM3 性能比 SK 海力士此前公布的要更进一步,但 SK 海力士作为 Rambus 的重要客户,Rambus 也会为其提供支持。

苏雷还透露,当前国内的一流 AI 芯片厂商都和 Rambus 有所接触,预计行业将会快速升级到 HBM3 标准。

二、Rambus 优势:市场经验丰富、支持多厂商制程节点

对于 Rambus 能够为客户提供的服务,Frank 提到 Rambus 在 HBM 市场中拥有丰富的经验和技术优势。

Rambus 在 2016 年就进入了 HBM 市场,其 HBM2E 内存子系统拥有行业中最快的 4Gbps 速率。

凭借产品性能,Rambus 获得了超过 50 个市场订单,是市场份额排名第一的 HBM IP 供应商。Rambus 的芯片开发基本一次就能成功,无需返工,提升了设计效率。

同时,Rambus 的 HBM2/2E PHY(端口物理层)支持台积电、三星等多个先进制程节点。其产品集成了 PHY、IO、Decap 等,其客户可以直接采用。

Rambus 也与 SK 海力士、三星等 DRAM 供应商关系紧密,其测试芯片已经经过了市场上所有供应商的 DRAM 验证,能够为客户提供便捷地服务。

三、2025 年全球数据使用量将达到 175ZB,AI 芯片市场将达百亿美元

Rambus 大中华区总经理苏雷分享了近年来 Rambus 所取得的成绩。Rambus 创建时间已经超过 30 年,公司总部位于美国加利福尼亚州,在欧盟和亚洲等地设有办事处,全球员工人数超过 600 人。

Rambus 拥有 3000 余项专利和应用,2020 年经营现金流达 1.855 亿美元,来自产品、合同等收入同比增长 41%。其主要的客户有三星、美光、SK 海力士等内存厂商和高通、AMD、英特尔等芯片厂商,Rambus 75% 以上的收入来自于数据中心和边缘计算产品销售。

从市场来说,人工智能/机器学习越来越多地应用于各个领域。预计到 2025 年,超过 25% 的服务器将用于人工智能领域,AI 芯片市场将达到 100 亿美元。

2025 年,全球数据使用量将达到 175ZB,年均复合增长率达 35%,服务器整体年增长率为 8%。苏雷称,Rambus 也将致力于使数据传输更快、更安全。

结语:HBM3 将推动 AI、HPC 应用发展

相对于 GDDR 显存,HBM 有着高带宽的特性,是数据密集型应用内存和数据处理瓶颈的解决方案之一。

本次 Rambus HBM3 IP 的推出,将再次推动 HBM 产品性能的提升,推动人工智能、高性能计算等应用发展。

相关资讯

推荐下载

-

下载

樱花漫画 v2.0.0 破解版

其他应用 |

樱花漫画app破解版是一款连载漫画阅读软件,里面小说漫画资源非常多,最近特别火的怦然心动和斗罗大陆这里都可以看,还有各种网络的热门精品小说,看久了漫画觉得厌倦,也可以切换到小说界面,阅读下精彩的小说哦,软件界面简洁,漫画和小说切换按钮就在软件顶部点击就能切换非常方便,这款破解版无需充值开通会员就能享受会员的专属小说漫画和会员加速线路。软件特色1、独家漫画资源:平台签约了数千个漫画小说作家,所有作品...

-

下载

画画相机 v1.4.8 安卓版

拍照美化 |

画画相机手机版是一款支持照片转换成素描画像的拍照软件。软件拥有超多强大得美颜功能,导入照片一键生成素描画像,再也不需要找人帮你画素描,百变风格,引领潮流新玩法。快来用画画相机记录你的生活吧!软件特色1、包含多种主题、滤镜、贴纸及五官调整功能,拍出百变风格2、滤镜美妆,智能美颜,推荐最适合自己脸型的妆容,打造自然时尚美妆;3、趣萌贴纸,分享好友和你拍同款。乐趣无限4、随意剪裁,适用于微信头像、手机壁...

-

下载

地摊人 v1.0.1 安卓版

生活实用 |

地摊人app是一款分享摆摊经验的平台软件,去哪里摆地摊,摆摊卖什么东西比较好,利润控制在多少比较合适,每天摆摊多长时间,这些摆地摊必备的经验你都能自这里学习到,而且上面还有很多优质低价货源信息提供参考,是地摊人必备的软件地摊人软件特色1、软件支持扫描识别地摊实物比价,不用费力讨价还价,做到价格心中有数;2、优良的地理位置,先进的摆摊经验让你生意更加兴隆;3、想摆摊的创业朋友,可以在这里学习成熟的摆...

-

下载

千千音乐 V8.2.1.0 安卓版

影音播放 | 27.1 MB

千千音乐APP是一款手机听歌播放软件,包含全面风格类型歌曲种类,致力打造专业,个性的音乐播放器。千千音乐软件特色1、歌曲曲库齐全,所有歌曲都可以免费下载,不收取费用;2、排行榜单每天实时更新,让你不错过每一首热门歌曲;3、喜欢的音乐可以一键收藏,创建不同风格的歌单,一目了然;4、根据你的喜好为你推荐同类型歌曲,精彩好歌听不腻;千千音乐软件特点1、每首歌都有高清mv视频,让你听歌同时还能感受视觉冲击...

-

下载

黑光图库 V2.0.23 安卓版

拍照美化 |

黑光图库APP是一款为摄影爱好者打造的作品分享社交平台。支持原创摄影分享,可以结识更多志同道合的摄影爱好朋友。黑光图库软件特色1、摄影作品涵盖面广泛,涉及超多领域,给你视觉享受;2、打造你自己专属的私人相册,喜欢的可以收藏,标签便捷;3、随意分享自己拍摄的作品,和其他摄影爱好者一起探讨优点和不足;黑光图库软件特点1、可以结交共同爱好的好友,相互评论学习更多摄影知识;2、每天为你推荐超多好的作品,寻...